Cara crawling data.

Jika kamu mencari artikel cara crawling data terbaru, berarti kamu sudah berada di blog yang tepat. Yuk langsung saja kita simak pembahasan cara crawling data berikut ini.

How Google Search Works Infographic Google Social Media Infographic Web Marketing From pinterest.com

How Google Search Works Infographic Google Social Media Infographic Web Marketing From pinterest.com

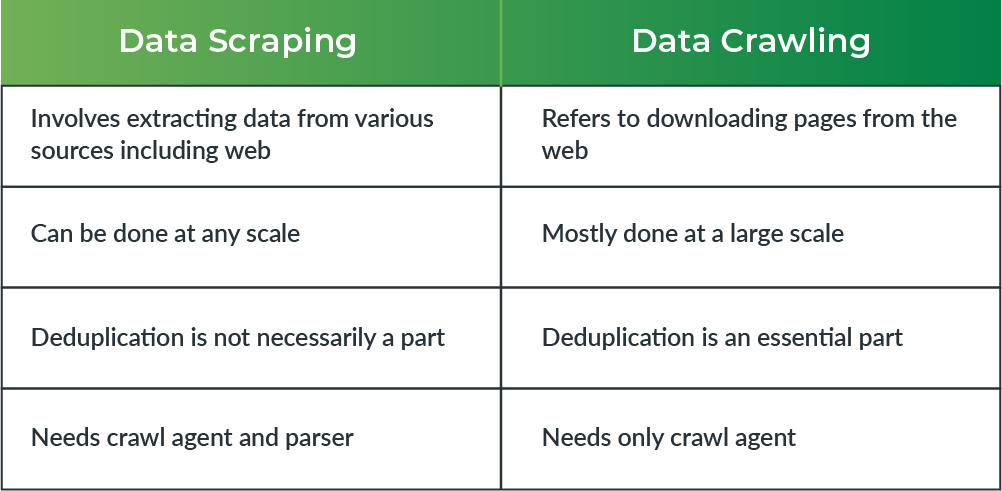

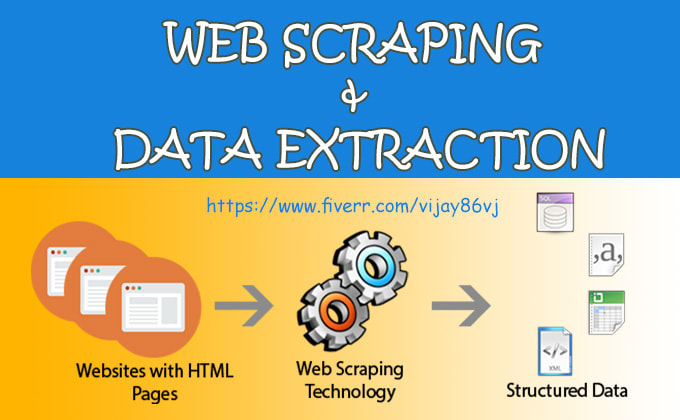

Anaconda jupyter notebook dan pandasKemudian disimpan. Web Crawling merupakan salah satu teknik pengumpulan data sekunder melalui media sosial yang bisa kamu terapkan dalam penelitian kamu. Cara Scraping Data Twitter Menggunakan Python Tanpa API Mengambil Data Twitter Menjadi CSV. Kalau php bisa gak ya.

Di artikel sebelumnya saya membahasa cara crawling data twitter baik melalui API maupun melalui page scrapping.

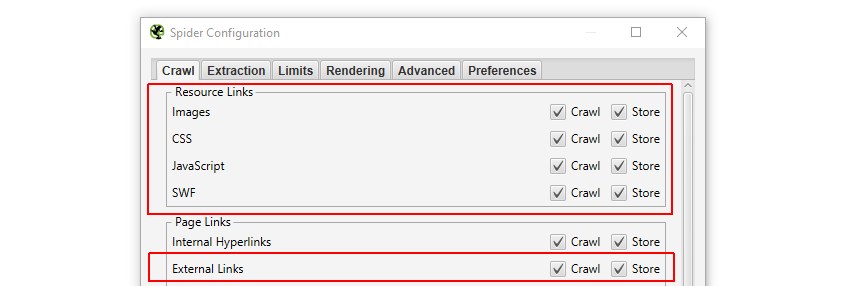

Crawling Data Twitter Menggunakan R. Dari cara-cara pengumpulan data tersebut sebagian besar perusahaan berbasis data pada kenyataannya menggunakan web crawler karena kebanyakan data yang dibutuhkan oleh perusahaan-perusahaan ini adalah dalam bentuk web page yang tidak bisa diakses menggunakan API tertentu. Cara Scraping Data Twitter Menggunakan Python Tanpa API Mengambil Data Twitter Menjadi CSV. Crawling Data Twitter search_tweets. Crawling Data Twitter Menggunakan R.

Source: theofy.world

Source: theofy.world

Okeh saya asumsikan sudah bisa ya lanjut ke step berikutnya. Tweepy yaitu library python. Secara default dalam sekali dijalankan akan memberikan. Okeh saya asumsikan sudah bisa ya lanjut ke step berikutnya. Nanti data tersebut dimasukkan ke database saya.

Crawling data twitter menggunakan python merupakan salah satu cara mengumpulkan data teks.

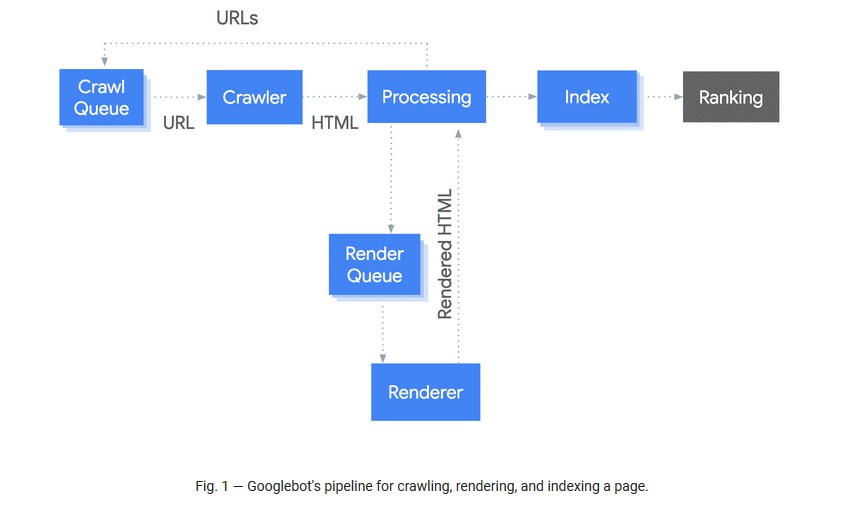

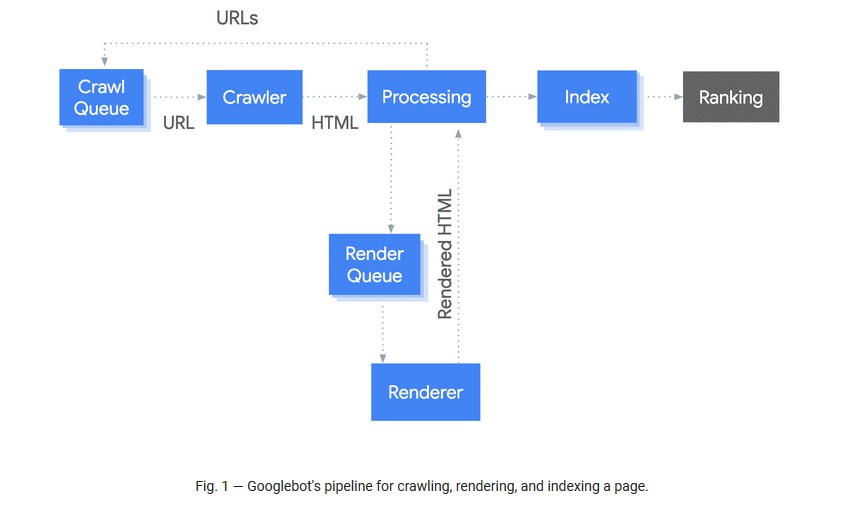

Tujuan utamanya adalah mengumpulkan data sehingga nantinya ketika pengguna mengetikkan keyword pencarian pada search engine maka search engine dapat dengan segera menampilkan website yang relevan. Dari cara-cara pengumpulan data tersebut sebagian besar perusahaan berbasis data pada kenyataannya menggunakan web crawler karena kebanyakan data yang dibutuhkan oleh perusahaan-perusahaan ini adalah dalam bentuk web page yang tidak bisa diakses menggunakan API tertentu. Tweepy yaitu library python. Tweepy yaitu library python.

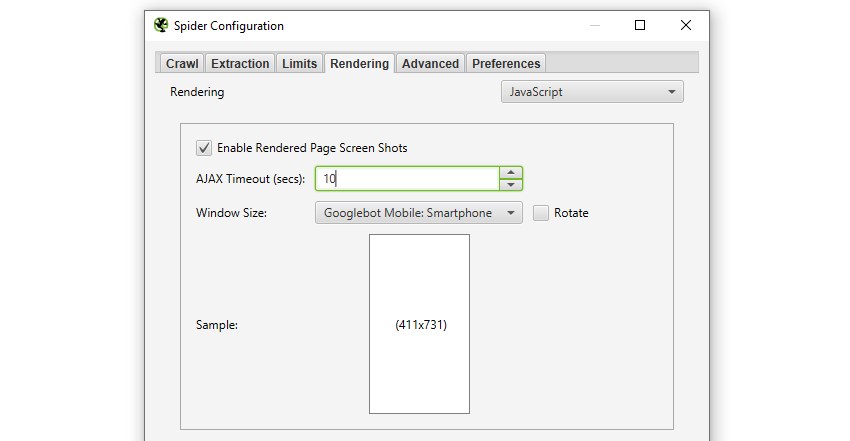

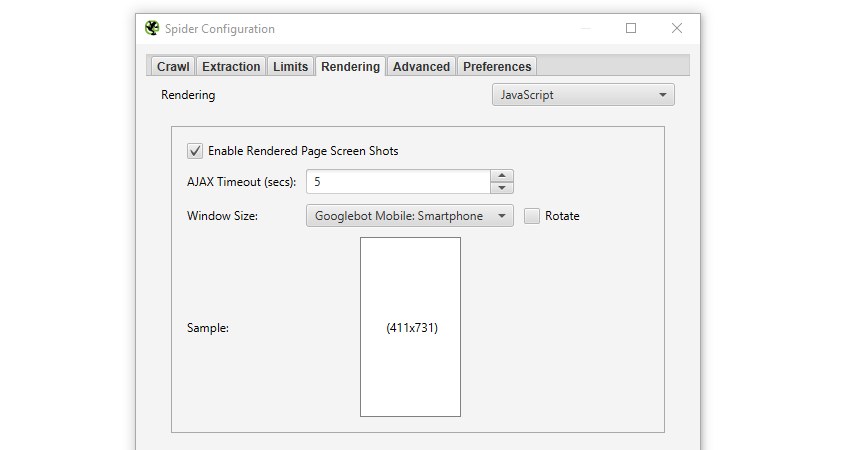

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Crawling Data Twitter Menggunakan R. Dari sosial media populer seperti facebook dan instagram twitter ini yang paling baik soal open access data. Dari contoh tersebut dapat dilihat bahwa anda bisa melakukan crawling atau mendapatkan data dari suatu user dengan contoh username gojekindonesia dan bisa mendapatkan data lebih dari 1. Kali ini giliran Facebook _.

Source: theofy.world

Source: theofy.world

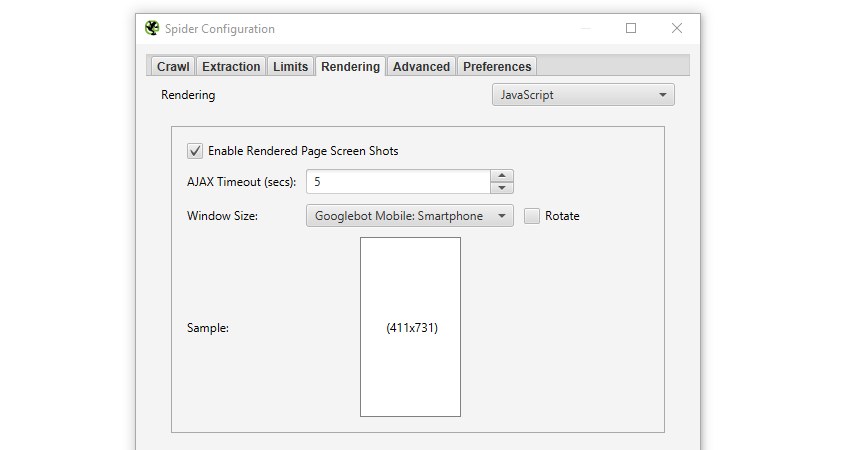

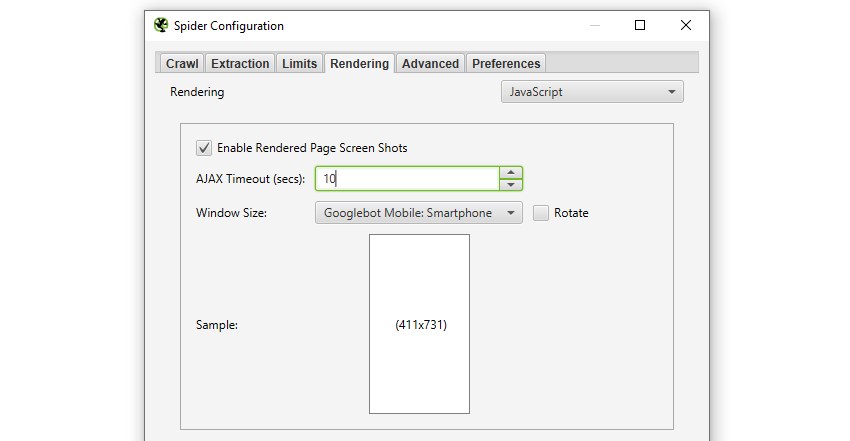

Cara crawling mengambil data dari twitter menggunakan tweepy. Misalkan saja waktu interaksi jumlah like gambar audio dan lain sebagainya. Maka dapat dikatakan Web Crawling adalah proses mengunjungi situs web membaca halaman web dan menemukan informasi dari suatu web mengindeks semua. Secara detail bagian bagian tersebut telah diterangkan di dokumentasi endpoint api twitter.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Kali ini giliran Facebook _. Cara Scraping Data Twitter Menggunakan Python Tanpa API Mengambil Data Twitter Menjadi CSV. Secara default dalam sekali dijalankan akan memberikan. Twitter memberikan akses kepada khalayak untuk mengkonsumsi data.

Step di bawah adalah langkah untuk crawling data twitter melalui python. Dari sosial media populer seperti facebook dan instagram twitter ini yang paling baik soal open access data. Anaconda jupyter notebook dan pandasKemudian disimpan. Kali ini giliran Facebook _.

Cara Scraping Data Twitter Menggunakan Python Tanpa API Mengambil Data Twitter Menjadi CSV.

Dengan banyaknya tipe data tentunya memiliki cara yang berbeda dalam mendapatkan data. Karena tak memungkinkan untuk mengetahui jumlah pasti berapa banyak halaman yang ada di internet web crawler ini memulai pekerjaannya berdasarkan daftar link halaman yang sudah ia kenal sebelumnya dari sitemap suatu website. Internet selalu berubah dan berkembang setiap waktunya. Crawling Data Twitter Menggunakan R. Saya harus belajar bahasa pemrograman apa nih.

Source: theofy.world

Source: theofy.world

Bagaimana Cara Kerja Crawler. Dari contoh tersebut dapat dilihat bahwa anda bisa melakukan crawling atau mendapatkan data dari suatu user dengan contoh username gojekindonesia dan bisa mendapatkan data lebih dari 1. Menampilkan timeline atau statustweet terbaru yang pernah di- posting oleh satu atau beberapa user. Analisis terhadap mediajejaring sosial social media analytics adalah alat yang ampuh untuk memahami sikap preferensi dan opini publik di berbagai sumber online. Nanti data tersebut dimasukkan ke database saya.

Anaconda jupyter notebook dan pandasKemudian disimpan. Internet selalu berubah dan berkembang setiap waktunya. Secara detail bagian bagian tersebut telah diterangkan di dokumentasi endpoint api twitter. Analisis terhadap mediajejaring sosial social media analytics adalah alat yang ampuh untuk memahami sikap preferensi dan opini publik di berbagai sumber online.

Dari contoh tersebut dapat dilihat bahwa anda bisa melakukan crawling atau mendapatkan data dari suatu user dengan contoh username gojekindonesia dan bisa mendapatkan data lebih dari 1.

Web Crawling merupakan salah satu teknik pengumpulan data sekunder melalui media sosial yang bisa kamu terapkan dalam penelitian kamu. Sesuai judulnya postingan ini akan membahas tentang cara mendapatkan data dari Twitter sebagai bahan analisis. Maka dapat dikatakan Web Crawling adalah proses mengunjungi situs web membaca halaman web dan menemukan informasi dari suatu web mengindeks semua. Mencari tweet yang memuat kata kunci tertentu.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Crawling Data Twitter search_tweets. Misalkan saja waktu interaksi jumlah like gambar audio dan lain sebagainya. Kali ini giliran Facebook _. Bagaimana Cara Kerja Crawler.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Web Crawling merupakan salah satu teknik pengumpulan data sekunder melalui media sosial yang bisa kamu terapkan dalam penelitian kamu. Sesuai judulnya postingan ini akan membahas tentang cara mendapatkan data dari Twitter sebagai bahan analisis. Kalau php bisa gak ya. Tweepy yaitu library python.

Source: theofy.world

Source: theofy.world

Tutorial Cara Crawling Data ada yang bisa ajarin saya cara crawling data di suatu website gak. Tutorial Cara Crawling Data ada yang bisa ajarin saya cara crawling data di suatu website gak. Bagaimana Cara Kerja Crawler. Tujuan utamanya adalah mengumpulkan data sehingga nantinya ketika pengguna mengetikkan keyword pencarian pada search engine maka search engine dapat dengan segera menampilkan website yang relevan.

Anaconda jupyter notebook dan pandasKemudian disimpan.

Saya harus belajar bahasa pemrograman apa nih. Tweepy yaitu library python. Secara detail bagian bagian tersebut telah diterangkan di dokumentasi endpoint api twitter. Namun demikian meng-crawl web page bukanlah perkara mudah. Bagaimana Cara Kerja Crawler.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Secara default dalam sekali dijalankan akan memberikan. Tweepy yaitu library python. Cara crawling mengambil data dari twitter menggunakan tweepy. Di artikel sebelumnya saya membahasa cara crawling data twitter baik melalui API maupun melalui page scrapping. Tweepy yaitu library python.

Kalau php bisa gak ya.

Tutorial Cara Crawling Data ada yang bisa ajarin saya cara crawling data di suatu website gak. Tujuan utamanya adalah mengumpulkan data sehingga nantinya ketika pengguna mengetikkan keyword pencarian pada search engine maka search engine dapat dengan segera menampilkan website yang relevan. Tweepy yaitu library python. Okeh saya asumsikan sudah bisa ya lanjut ke step berikutnya.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Web Crawling merupakan salah satu teknik pengumpulan data sekunder melalui media sosial yang bisa kamu terapkan dalam penelitian kamu. Sebenarnya saat ini tidak hanya teks yang bisa didapat dari twitter. Secara detail bagian bagian tersebut telah diterangkan di dokumentasi endpoint api twitter. Dari cara-cara pengumpulan data tersebut sebagian besar perusahaan berbasis data pada kenyataannya menggunakan web crawler karena kebanyakan data yang dibutuhkan oleh perusahaan-perusahaan ini adalah dalam bentuk web page yang tidak bisa diakses menggunakan API tertentu.

Source: pinterest.com

Source: pinterest.com

Sebenarnya saat ini tidak hanya teks yang bisa didapat dari twitter. Saya harus belajar bahasa pemrograman apa nih. Karena tak memungkinkan untuk mengetahui jumlah pasti berapa banyak halaman yang ada di internet web crawler ini memulai pekerjaannya berdasarkan daftar link halaman yang sudah ia kenal sebelumnya dari sitemap suatu website. Dari contoh tersebut dapat dilihat bahwa anda bisa melakukan crawling atau mendapatkan data dari suatu user dengan contoh username gojekindonesia dan bisa mendapatkan data lebih dari 1.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Nanti data tersebut dimasukkan ke database saya. Web adalah lautan informasi dengan miliaran web pages laman web dibuat setiap hari. Crawling Data Twitter Menggunakan R. Menampilkan timeline atau statustweet terbaru yang pernah di- posting oleh satu atau beberapa user.

Menampilkan timeline atau statustweet terbaru yang pernah di- posting oleh satu atau beberapa user.

Anaconda jupyter notebook dan pandasKemudian disimpan. Analisis terhadap mediajejaring sosial social media analytics adalah alat yang ampuh untuk memahami sikap preferensi dan opini publik di berbagai sumber online. Kali ini giliran Facebook _. Menampilkan timeline atau statustweet terbaru yang pernah di- posting oleh satu atau beberapa user. 30 Jan 2015 4 minute read.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Okeh saya asumsikan sudah bisa ya lanjut ke step berikutnya. Menampilkan timeline atau statustweet terbaru yang pernah di- posting oleh satu atau beberapa user. Tweepy yaitu library python. Misalkan saja waktu interaksi jumlah like gambar audio dan lain sebagainya. Internet selalu berubah dan berkembang setiap waktunya.

Kali ini giliran Facebook _.

Kali ini giliran Facebook _. Secara default dalam sekali dijalankan akan memberikan. Dari sosial media populer seperti facebook dan instagram twitter ini yang paling baik soal open access data. Cara Scraping Data Twitter Menggunakan Python Tanpa API Mengambil Data Twitter Menjadi CSV.

Source: screamingfrog.co.uk

Source: screamingfrog.co.uk

Sesuai judulnya postingan ini akan membahas tentang cara mendapatkan data dari Twitter sebagai bahan analisis. Saya harus belajar bahasa pemrograman apa nih. Teknik pengumpulan data sekunder adalah cara yang dapat digunakan untuk mengumpulkan data yang sudah tersedia tanpa perlu melakukan wawancara dan survey langsung di lapangan. Karena tak memungkinkan untuk mengetahui jumlah pasti berapa banyak halaman yang ada di internet web crawler ini memulai pekerjaannya berdasarkan daftar link halaman yang sudah ia kenal sebelumnya dari sitemap suatu website. Sebenarnya saat ini tidak hanya teks yang bisa didapat dari twitter.

Source: pinterest.com

Source: pinterest.com

Di artikel sebelumnya saya membahasa cara crawling data twitter baik melalui API maupun melalui page scrapping. Bagaimana Cara Kerja Crawler. Misalkan saja waktu interaksi jumlah like gambar audio dan lain sebagainya. Di artikel sebelumnya saya membahasa cara crawling data twitter baik melalui API maupun melalui page scrapping. 30 Jan 2015 4 minute read.

Source: pinterest.com

Source: pinterest.com

Dari cara-cara pengumpulan data tersebut sebagian besar perusahaan berbasis data pada kenyataannya menggunakan web crawler karena kebanyakan data yang dibutuhkan oleh perusahaan-perusahaan ini adalah dalam bentuk web page yang tidak bisa diakses menggunakan API tertentu. Crawling Data Twitter Menggunakan R. Cara crawling mengambil data dari twitter menggunakan tweepy. Misalkan saja waktu interaksi jumlah like gambar audio dan lain sebagainya. Ada 2 library yang dibutuhkan untuk crawling twitter JupyterNotebook dari Anaconda Tweepy cara installnya – pip install tweepy conda install tweepy Langkah selanjutnya ketika sudah menginstall semua libary yang dibutuhkan yaitu.

Situs ini adalah komunitas terbuka bagi pengguna untuk berbagi apa yang mereka cari di internet, semua konten atau gambar di situs web ini hanya untuk penggunaan pribadi, sangat dilarang untuk menggunakan artikel ini untuk tujuan komersial, jika Anda adalah penulisnya dan menemukan gambar ini dibagikan tanpa izin Anda, silakan ajukan laporan DMCA kepada Kami.

Jika Anda menemukan situs ini baik, tolong dukung kami dengan membagikan postingan ini ke akun media sosial seperti Facebook, Instagram dan sebagainya atau bisa juga save halaman blog ini dengan judul cara crawling data dengan menggunakan Ctrl + D untuk perangkat laptop dengan sistem operasi Windows atau Command + D untuk laptop dengan sistem operasi Apple. Jika Anda menggunakan smartphone, Anda juga dapat menggunakan menu laci dari browser yang Anda gunakan. Baik itu sistem operasi Windows, Mac, iOS, atau Android, Anda tetap dapat menandai situs web ini.